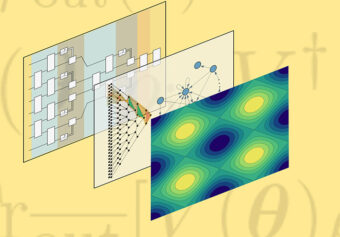

Una nuova prova che è possibile garantire l’addestramento di determinate reti convoluzionali quantistiche apre la strada all’intelligenza artificiale quantistica per aiutare nella scoperta di materiali, oltre che in molte altre applicazioni. Crediti: Lanl

Le reti neurali convoluzionali in esecuzione su computer quantistici hanno generato un notevole clamore per la loro potenzialità di analizzare i dati quantistici meglio di quanto possano fare i computer classici. Tuttavia, l’applicazione di queste reti neurali a grandi set di dati è sempre stata un problema, per via di una sorta di “tallone d’Achille” noto come Barren Plateau, o altopiano sterile. Ma ora una nuova ricerca condotta da un team del Los Alamos National Laboratory, pubblicata su Physical Review X, sembra essere riuscita a superarlo.

Media Inaf ha intervistato Nicolò Parmiggiani, ricercatore dell’Istituto nazionale di astrofisica, esperto di machine learning e vincitore della prima edizione del Premio nazionale per la ricerca sui big data e l’intelligenza artificiale per i suoi studi sulle tecnologie di apprendimento automatico applicate all’analisi dei dati prodotti dal telescopio spaziale Agile.

Parmiggiani, può spiegarci di cosa si occupa questo nuovo studio e perché ci lascia ben sperare per l’analisi di sistemi complessi?

«Nell’articolo viene descritto un modello di rete neurale quantistica (Qnn) che si basa sull’architettura delle Convolutional Neural Network (Cnn) utilizzate nel machine learning classico. Le Cnn sono una particolare architettura di reti neurali in cui i neuroni (artificiali) sono connessi tra loro con uno schema ispirato alla struttura della corteccia visiva animale. Questi modelli hanno ottenuto risultati di successo in vari ambiti differenti, tra i quali l’astrofisica dove spesso vengono utilizzate per analizzare immagini bidimensionali e risolvere problemi di classificazione o di object detection. Noi, ad esempio, come team Agile abbiamo sviluppato un modello di Cnn per identificare i Gamma-Ray Bursts all’interno delle mappe di conteggi prodotte con lo strumento Grid a bordo del satellite».

Quindi non solo machine learning classico, ma anche quantistico. In cosa si differenziano i due?

«Negli ultimi anni molte ricerche sono state portate avanti per unire i vantaggi dei computer quantistici con le reti neurali. Le reti neurali quantistiche sono modelli di reti neurali che si basano sulla meccanica quantistica per sviluppare algoritmi più efficienti sfruttando le proprietà dell’informazione quantistica. Nell’articolo viene descritta l’architettura delle Quantum Convolutional Neural Networks (Qcnn) che utilizzano gli stessi principi dall’architettura delle Cnn classiche per analizzare uno stato quantistico invece che input classici, come ad esempio immagini. Lo scopo principale delle Qcnn è quello di poter analizzare sistemi quantistici molto complessi che non sarebbero trattabili con il machine learning classico. Ad esempio, un problema che può essere analizzato con le Qnn è il problema a molti corpi».

Ci sono dei limiti a questo approccio?

«Nonostante le enormi potenzialità, il machine learning quantistico ha alcune problematiche, tra le quali il cosiddetto Barren Plateau, analogo al problema del Vanishing Gradient che si ha nel machine learning classico. Durante la fase di training delle reti neurali classiche molto profonde (con tanti layer), il gradiente di ottimizzazione dei parametri che compongono il modello può diventare molto piccolo, non permettendo l’aggiornamento dei parametri della rete neurale che non viene addestrata correttamente. Una situazione molto simile si può avere anche nelle Qnn».

Perché questo problema viene ricondotto visivamente a un plateau, ossia un altopiano?

«La metafora dell’altopiano, utilizzata nel quantum machine learning, nasce dal fatto che se l’algoritmo deve minimizzare una funzione di costo (per ottimizzare i parametri) cercherà di identificare la direzione (il gradiente) per raggiungere le valli il cui la funzione di costo è più bassa. Tuttavia, può capitare che l’algoritmo non riesca a trovare una direzione da percorrere e quindi si ritrovi nel cosiddetto altopiano in cui tutte le direzioni sembrano uguali o con differenze molto piccole. In questa situazione la Qnn spesso non può essere addestrata in modo efficiente e quindi risulta inutilizzabile. Questo problema può peggiorare con il crescere del numero di parametri e quindi non consente di sfruttare i vantaggi dei computer quantistici per analizzare sistemi complessi di grandi dimensioni».

Qual è l’importanza dello studio pubblicato dal team del Los Alamos National Laboratory?

«Lo studio pubblicato dimostra che le Qcnn, le quali sono Qnn realizzate con una particolare architettura, non hanno questo problema del Barren Plateau ma possono essere gestite con una complessità che cresce in modo polinomiale rispetto alla dimensione del sistema e che garantisce la possibilità di addestrare il modello. Infatti, uno dei principali vantaggi di utilizzare le Qnn è quello di poter analizzare con complessità polinomiale sistemi che avrebbero una complessità esponenziale nel machine learning classico e quindi ottenere un netto vantaggio computazionale. I due teoremi dimostrati in questo articolo sono quindi molto importanti per garantire l’applicabilità delle Qcnn e per il futuro delle reti neurali quantistiche».

Per saperne di più:

- Leggi su Physical Review X l’articolo “Absence of Barren Plateaus in Quantum Convolutional Neural Networks” di Arthur Pesah, M. Cerezo, Samson Wang, Tyler Volkoff, Andrew T. Sornborger e Patrick J. Coles