A quasi un anno di distanza, Media Inaf ha incontrato nuovamente Daniela Paoletti, ricercatrice dell’Inaf Oas di Bologna e prima autrice di un nuovo studio che indaga in modo originale la storia della reionizzazione, il periodo – non ancora ben definito – in cui il gas primordiale, di cui era pervaso l’universo nelle prime fasi della sua evoluzione, passa dallo stato neutro a quello ionizzato. Il lavoro – dal suggestivo titolo “Dark Twilight Joined with the Light of Dawn to Unveil the Reionization History” (l’oscurità del crepuscolo insieme alla luce dell’alba per svelare la storia della reionizzazione) – presenta un’estesa analisi della storia della reionizzazione basata su recenti dati cosmologici e astrofisici. Tra gli autori anche Dhiraj Kumar Hazra, Fabio Finelli di Inaf Oas e il premio Nobel per la fisica nel 2006 George Smoot. Oltre a questo lavoro, nello stesso periodo è stato presentato anche un altro articolo che la vede tra gli autori, che riporta uno studio dettagliato su ciò che gli ultimi dati di Planck hanno da dire al di là del modello standard di inflazione. In questa calda giornata estiva, scopriamo insieme a lei i dettagli dell’analisi, i risvolti e le speranze per il futuro.

Impressione artistica che mostra una parte della storia dell’universo, incentrata sull’epoca della reionizzazione, un processo che ha ionizzato la maggior parte del materiale dell’universo. Da sinistra a destra: la luce più antica dell’universo, le prime stelle, il processo di reionizzazione e le prime galassie. Crediti: Esa – C. Carreau

A un anno dalla pubblicazione del vostro studio sulla storia della reionizzazione, ne state per pubblicare uno nuovo sempre sullo stesso tema scottante. Di cosa si tratta?

«Si tratta di uno studio su come il buio del crepuscolo e la luce dell’alba dell’universo, insieme, possono farci capire come potrebbe essere andata una delle fasi più importanti della storia dell’universo. L’articolo è il prosieguo di quello che abbiamo pubblicato un anno fa sulla rivista Physical Review Letters nel quale avevamo presentato un approccio originale per studiare la storia dell’universo primordiale, mettendo insieme i dati astrofisici e il fondo cosmico a microonde (o Cmb, dall’inglese cosmic microwave background). In questo articolo andiamo a descrivere tale approccio nel dettaglio e a presentare tante cose in più, rispetto all’articolo precedente, che per ragioni di spazio all’epoca non abbiamo potuto presentare».

Come le è venuta l’idea del titolo, così suggestivo?

«L’idea del titolo mi è venuta quando preparavo il seminario su Physical Review Letters. L’aspetto innovativo del nostro approccio è mettere insieme due tipologie di dati completamente diversi: la radiazione di fondo a microonde e la radiazione ultravioletta. La prima, da sempre definita la prima luce dell’universo, è costituita dai primi fotoni che sono stati emessi che però, pensandoci bene, sono gli stessi del primo crepuscolo, perché quando questa radiazione si è raffreddata, l’universo è entrato in quella che viene chiamata era oscura. Mentre la radiazione ultravioletta rappresenta un tracciante delle prime stelle: traccia quindi l’alba dell’universo, quando esce dalla notte dell’era oscura. Se il titolo fosse stato in italiano avrei usato la parola aurora, che secondo me sarebbe la definizione più bella, ma in inglese aurora e crepuscolo vengono indicati nello stesso modo. Quindi ho usato alba, come terminologia, perché mi piaceva questa idea di mettere insieme il crepuscolo prima della notte e la luce, dopo la notte».

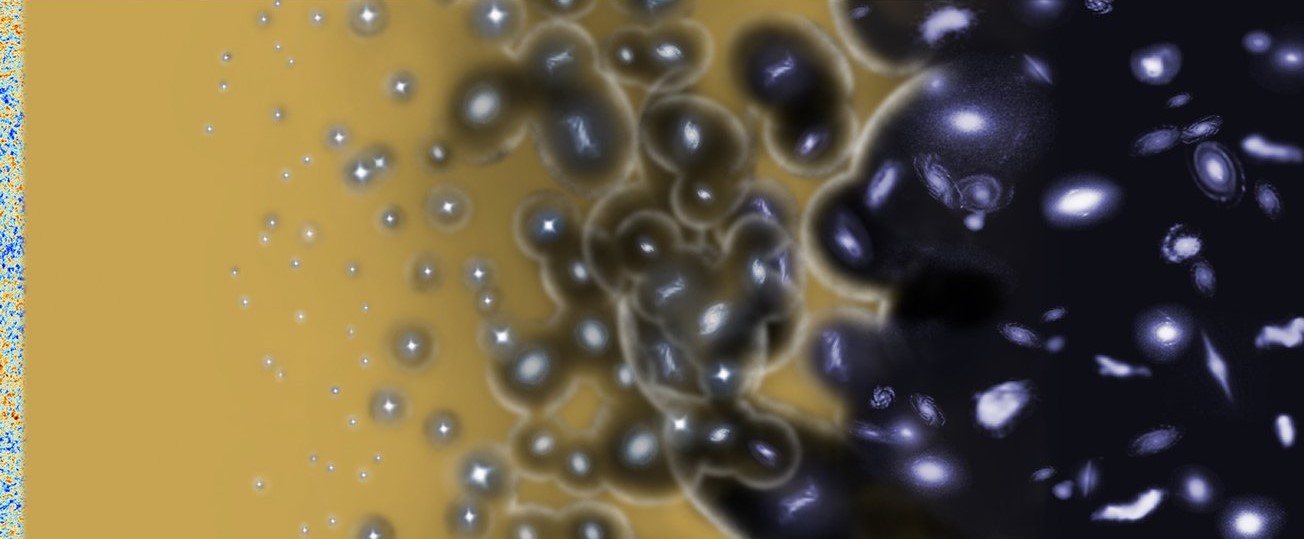

La figura mostra il confronta tra le storie di ionizzazione che vogliono i dati dei quasar e della UV combinati separatamente con la Cmb versus la combinazione di tutti e tre. Crediti: Paoletti et al.

Radiazione a microonde e radiazione ultravioletta: come avete fatto a conciliare dati così diversi?

«Sono due tipologie di dati totalmente diversi e proprio perché sono così diversi abbiamo dovuto ideare e sviluppare questa tecnica nuova che invece di andare a valutare la frazione di materia ionizzata al variare del tempo, risolve l’equazione per la frazione di ionizzazione, riuscendo così a testare anche quelli che sono i dati della radiazione ultravioletta, che altrimenti non potremmo utilizzare nell’approccio classico. Questi dati ci stanno dicendo cosa sta succedendo alla sorgente che ionizza, ossia alle prime stelle. Dopodiché usiamo anche altri dati, che in questo lavoro si sono dimostrati molto interessanti: i dati dei quasar e quelli dei gamma ray burst (Grb). Alcuni oggetti a redshift molto alti, quindi molto lontani, ci possono dire qual è la situazione della ionizzazione attorno alla sorgente, nel loro mondo locale. Se assumiamo che questo sia rappresentativo anche di ciò che è al di fuori, ci danno un’idea puntuale di quello che sta succedendo a quel redshift, in quel momento».

Quindi il metodo è lo stesso presentato nel 2020?

«Sì, questa è la base del metodo che avevamo già sviluppato all’interno dello studio presentato su Physical Review Letters nel 2020, ma in questo caso siamo andati a vedere cosa succede quando iniziamo a utilizzare dei dati diversi o a cambiare delle assunzioni. La primissima cosa che abbiamo fatto è stata quella di andare a verificare cosa succede nel momento in cui nella sorgente di reionizzazione lasciamo libero un termine che altrimenti verrebbe fissato dalle simulazioni, perché è un termine su cui abbiamo pochissimi dati e quelli che abbiamo sono poco sensibili. Nel primo lavoro lo avevamo fissato al valore delle simulazioni mentre adesso lo abbiamo lasciato libero di farsi guidare dai dati e abbiamo visto che in realtà soprattutto i dati dei quasar hanno una buona capacità di vincolarlo e che, fortunatamente, è risultato essere perfettamente in accordo con le simulazioni. Questo ha quindi confermato quello che avevamo assunto in precedenza».

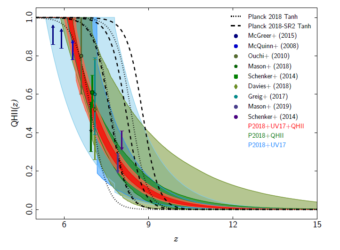

La figura mostra la differenza delle due storie di ionizzazione con differenti tagli in magnitudine, dove è evidente come il taglio a 15 induca una reionizzazione più morbida. Crediti: Paoletti et al.

Qual è la novità principale del nuovo studio?

«Un risultato estremamente interessante di questo nuovo studio è quando andiamo a cambiare i dati ultravioletti. Per la luminosità ultravioletta, quello che si va a misurare con i nostri strumenti è la funzione di luminosità, che poi convertiamo in densità di luminosità di radiazione ultravioletta. Siccome questa funzione di luminosità deve essere integrata, dobbiamo scegliere una magnitudine di taglio. In altre parole, non consideriamo sorgenti che sono più deboli del valore assunto come taglio. Finora, avevamo sempre assunto un valore di magnitudine abbastanza conservativo pari a meno 17, visto che per le sorgenti più deboli i dati mostrano un cambiamento di comportamento della funzione di luminosità che non sappiamo se sia reale oppure dipenda dall’incertezza sui dati. Ora abbiamo invece usato un taglio più aggressivo, più ottimistico. Ci siamo domandati cosa succederebbe se andassimo a meno 15. Con questo nuovo taglio stiamo di fatto considerando i contributi di sorgenti tanto lontane e tanto deboli, ma che sono tante e che pertanto portano a una storia della reionizzazione leggermente diversa. Notiamo che si inizia ad avere un contributo a redshift più alti: invece che essere una salita estremamente ripida, diventa più lenta, che dura di più proprio perché si ha un contributo da queste sorgenti molto deboli, in grado di ionizzare».

Il dubbio che non stiate considerando sorgenti realistiche l’avete ancora?

«Sì, quello resta sempre. Ovviamente le barre di errore si allargano perché sono misure più difficili. Ma il bello è che a ottobre lanciano Jwst che vedrà benissimo tutta quella coda che stiamo considerando noi. Io sto fremendo per fare le predizioni per Jwst perché sono curiosissima di vedere quale sarà l’impatto nel momento in cui le barre di errore scenderanno. Perché se veramente questo contributo delle sorgenti è così grande, il modello classico che viene utilizzato in cosmologia – che prevede una transizione ripidissima che dura pochissimo – inizia a essere problematico, perché a quel punto in realtà l’astrofisica ci starebbe dicendo che la reionizzazione è un po’ più lenta. Dobbiamo sempre tenere conto che la reionizzazione, al di là dell’importanza in sé – perché è una transizione di fase, quando l’intero universo cambia stato completamente – è fondamentale in cosmologia, perché rappresenta una delle nostre incertezze più grandi. Basti pensare che lo spessore ottico – il parametro che concretizza la reionizzazione nel fondo cosmico a microonde – è l’unico che, dopo Planck, ha più dell’1 per cento di errore. Va quindi a impattare tutta una serie di modelli estesi, tra cui abbiamo dimostrato anche i modelli di estensione dell’inflazione, come quelli dell’altro articolo che abbiamo scritto».

Gli esperimenti futuri già in programma potranno aiutare in questo senso?

«Sì, con la generazione di esperimenti cosmologici che verrà nei prossimi anni, dobbiamo essere particolarmente attenti a come verrà considerata la reionizzazione e la possibilità di utilizzare questi dati astrofisici per farci dire com’è andata la storia della reionizzazione potrebbe, a cascata, anche avere un impatto su quelli che sono i vincoli ai parametri cosmologici. Inoltre è molto interessante, sempre per il futuro, quello che abbiamo dimostrato sui dati dei quasar, che si son rivelati molto potenti perché – sebbene si estendano meno in redshift rispetto alla radiazione ultravioletta – sono dei punti precisi della frazione di reionizzazione. Mi faceva notare George Smoot che effettivamente nel futuro, con Desi e Euclid, si inizia a parlare di avere non più cinque, sei, dieci punti bensì delle bande di migliaia di quasar. Quindi nei prossimi dieci anni cambierà completamente anche l’approccio e la prospettiva».

«Uno strumento che avrebbe potuto fare delle cose eccezionali sarebbe stato Theseus, perché i gamma ray burst sono potentissimi: mentre il quasar ha un’emissione continua e quindi esso stesso ionizza il mezzo intorno a sé, nel caso del Grb no perché troppo veloce. Non fa in tempo a ionizzare. È proprio un punto preciso che indica quella frazione. Purtroppo noi, nella trattazione che abbiamo utilizzato, ne abbiamo solo uno di punti, che però fa già vedere come un singolo punto sulla dozzina di punti usati è in grado di restringere le barre di errore».

Quali dati astrofisici state utilizzando? A che distanza?

«Utilizziamo sei ammassi di galassie dell’Hubble Frontier Field. I quasar usati arrivano fino a redshift 8 mentre le sorgenti ultraviolette, interpolando, arrivano fino a redshift 10».

Esiste uno studio parallelo a questo, sottomesso negli stessi giorni, con un titolo altrettanto curioso che ricorda Toy Story. Di cosa parla?

«Il titolo originale di questo studio di Dhiraj – il primo autore che era a Bologna fino a gennaio 2020 mentre ora è professore a Imsc Chennai (India) – era proprio “Inflation story: to slow-roll and beyond” (verso lo slow-roll e oltre, simile al leitmotiv di Toy Story) perché lo slow-roll è il modello standard di inflazione e da quello “vai oltre”. Già quello è il non plus ultra ma noi andiamo oltre. L’idea era quella, citando appunto Buzz Lightyear. Un paio di autori non erano proprio d’accordissimo perché di fatto lo slow-roll l’abbiamo considerato come base di partenza, quindi non sarebbe stato corretto usare il “to”. Alla fine ovviamente il “to” l’abbiamo eliminato anche se a noi due piaceva perché riprendeva il voler andare oltre di Buzz e, pensandoci bene, la nostra fine è simile a quella dell’eroe di Toy Story: ci proviamo, ad andare oltre, ma c’è un problema. Sappiamo che il modello standard è un bellissimo fit ai dati, ma sappiamo anche che Planck ha confermato quello che già avevamo visto con Wmap, ossia che in questi dati ci sono delle anomalie. Queste anomalie sono estremamente sfuggenti perché sono tutte a 2.8 sigma di significatività, quando la soglia per dire che una cosa è anomala è 3 sigma. Quindi siamo un po’ in un limbo che non ci permette di capire se ciò che stiamo vedendo è una fluttuazione statistica o è davvero un’anomalia».

Se fosse un’anomalia sarebbe più intrigante?

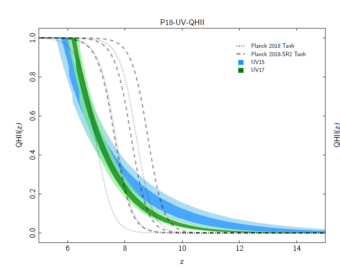

«Già, la cosa bella è andare a vedere se è un’anomalia. Due delle anomalie più grandi sono la mancanza di potenza alle grandissime scale angolari, che è stata osservata e confermata da Planck, e piccole oscillazioni nello spettro di potenza angolare. Sono questi blocchi di oscillazioni, oppure singole oscillazioni, che vengono chiamate features (caratteristiche) che nel modello standard non vengono prodotte. Una delle possibilità potrebbe essere quella che l’inflazione non fosse stata tutta slow-roll: abbiamo un campo scalare – quello che genera l’inflazione – che si muove molto lentamente su un potenziale estremamente piatto, che se prima di finire a rotolare lentamente sul potenziale piatto avesse avuto un potenziale un po’ meno piatto, oppure avesse fatto un salto o una cuspide, allora potrebbe portare a questa perdita di potenza e alla generazione delle piccole oscillazioni».

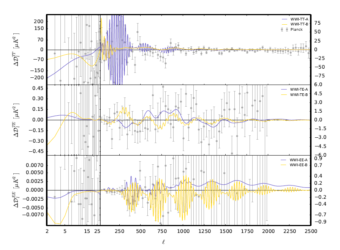

Spettri di potenza dei residui dei best fit che mostrano la mancanza di potenza e le oscillazioni che sono state studiate. Crediti: Hazra et al.

Come si fa per verificarlo?

«Di solito quello che si deve fare, che è stato trattato in moltissimi casi (anche nell’articolo di Planck dell’inflazione) prevede che si prendano diversi modelli fisici che vanno a vedere se i dati vengono fittati meglio o peggio. In questo caso la cosa carina è che si usa questo framework che si chiama Wiggly Whipped Inflation – letteralmente, inflazione oscillante frustata. Si tratta di un approccio fenomenologico: noi non ci chiediamo cosa ha causato quella cosa, ma ci chiediamo: se il potenziale inflazionario fosse fatto in una certa maniera, riusciamo a fittare i dati? Ovviamente, se fittiamo meglio i dati allora si può essere ragionevolmente sicuri di aver trovato un modello inflazionario che funziona meglio. Prima c’è la frustata – il cosiddetto potenziale whipped inflation che ci dice che prima il campo scalare rotolava un po’ più velocemente, ma poi inizia a fare lo slow-roll. In questo caso ho una carenza di potenza perché quando il capo rotola velocemente non genera tante perturbazioni; le genera quando arriva sullo slow-roll. Quindi si ha questa mancanza di potenza. Poi si va a testare quando sono presenti anche le wiggle, ossia queste piccole oscillazioni. Queste oscillazioni possono essere prodotte con delle discontinuità: nel momento in cui il potenziale ha un saltino, viene generata una wiggle. Se il salto è più grosso, ne generi tante a determinate scale, che dipendono da quanto salti. È un framework generale che semplicemente ci dà un’idea di cosa possa fittare meglio i dati».

Sembra semplice, ma immagino che in realtà non lo sia…

«I problemi sono due. Da un lato sappiamo che se usassimo 100mila parametri potremmo fittare l’intero universo. Potrei scrivere una lagrangiana dell’universo dipendente da 150 parametri e avrei la funzione dell’onda dell’universo. Ma non funziona così perché i gradi di libertà sarebbero troppi. Quindi dire che un modello migliora i dati è sempre un gioco di equilibrio tra quanto il modello è libero – quanti gradi di libertà ha – e quanto fitta meglio i dati. Se il modello, come ci è successo in alcuni di questi casi, fitta meglio i dati rispetto al modello standard ma usa tanti parametri, “non vale”. Inoltre, c’è da dire che i dati di Planck del 2018 hanno ridotto l’evidenza delle anomalie. In temperatura c’è ancora la perdita di potenza, però è stata leggermente ridotta rispetto a prima e il cambiamento è stato il fatto che nei dati di anche 2018 utilizziamo solo Planck alle grandi scale mentre invece prima, nel 2015, usavamo anche la mappa di Haslam e Wmap».

Qual è la novità in questo secondo studio?

«La novità sta nel fatto che abbiamo utilizzato anche la polarizzazione. Teoricamente la stessa cosa che viene fatta in temperatura si può fare in polarizzazione. Il problema è che nella polarizzazione, sulle grandi scale angolari, c’è la reionizzazione che va ad aumentare la potenza, mascherando un eventuale calo di potenza. Se la temperatura favorisce ancora i modelli che generano questa carenza di potenza, quando si considera la polarizzazione in realtà diventa evidente che questi modelli non sono favoriti in alcun modo rispetto al modello standard di slow-roll con uno spettro di potenza con legge di potenza. Oltre a questo, c’è un’altra novità: andare a utilizzare per le piccole scale angolari (minori di circa 8 gradi) non la likelihood ufficiale di Planck bensì quella di CamSpec, la versione non binnata, che tiene conto di tutti i singoli punti senza considerare le medie. Questa likelihood è frutto di una rielaborazione dei dati di Planck fatta da George Efstathiou e Steven Gratton successivamente alla pubblicazione dei risultati di Planck, i quali riescono a utilizzare più cielo, migliorando leggermente le barre di errore. Abbiamo voluto utilizzare quella perché è più completa e più evoluta. Al momento non ci sono evidenze a favore di questi modelli più particolari rispettano a un Lambda Cdm».

Cosa ci riserva il futuro, su questo fronte?

«Il futuro sarà molto interessante per due ragioni. La prima legata al miglioramento dei dati di Cmb grazie a LiteBird che ci permetterà di studiare la polarizzazione “E” limitata solo dalla varianza cosmica. Poi si avranno gli esperimenti a terra, che andranno a tracciare le piccole e medie scale dove sono presenti queste oscillazioni, che potranno essere viste in maniera più precisa rispetto ai dati di Planck. Inoltre, c’è la struttura a grande scala: siccome questa oscillazione è presente anche alle piccole scale, può essere vista anche da un esperimento come Euclid. Un’altra possibilità è quella di usare le non Gaussianità, perché gli stessi effetti di oscillazioni che si vedono nello spettro di potenza si vedono anche nei momenti di ordine superiore, quindi nelle non Gaussianità».

Quindi, per ora, nessuna novità significativa sulla storia dell’inflazione?

«Per il momento i dati di Planck ci dicono che ancora preferiscono un modello standard. Ma le prospettive per il futuro sono buone: nei prossimi dieci anni mi aspetto che potremo davvero iniziare a dire se è stato solamente un modello standard di slow-roll oppure no. Per ora siamo come Buzz: non possiamo andare molto più lontano della nostra stanza del modello standard ma ricordiamoci che anche Buzz trovò il suo razzo e spiccò il volo per davvero e così sarà per noi coi dati futuri, e forse andremo davvero oltre lo slow roll».

Per saperne di più:

- Leggi su arXiv il pre-print dell’articolo “Dark Twilight Joined with the Light of Dawn to Unveil the Reionization History” di Daniela Paoletti, Dhiraj Kumar Hazra, Fabio Finelli, George F. Smoot

- Leggi su arXiv il pre-print dell’articolo “Inflation Story: slow-roll and beyond” di Dhiraj Kumar Hazra, Daniela Paoletti, Ivan Debono, Arman Shafieloo, George F. Smoot, Alexei A. Starobinsky