Del fatto che l’universo s’espandesse, che lo spazio fra una galassia e l’altra andasse aumentando con il tempo, se n’era già accorto Edwin Hubble sul finire degli anni Venti. Ma non si limita a espandersi, l’Universo: lo fa accelerando. Questo significa che, più è grande la distanza fra una galassia e una qualsiasi altra, maggiore sarà la velocità alla quale le due continueranno ad allontanarsi.

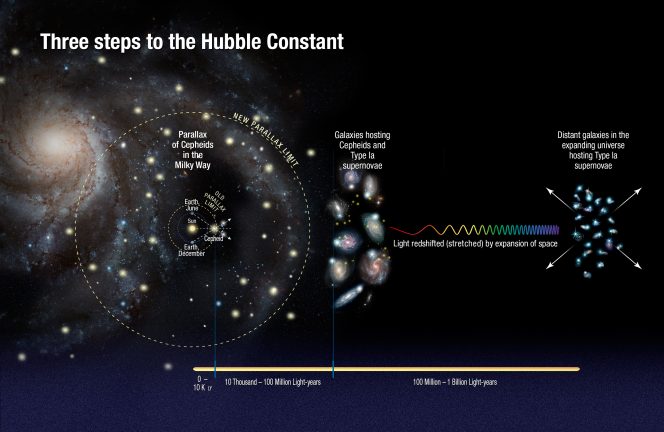

Quanto maggiore? Il valore, uno fra i pochi parametri fondamentali della cosmologia contemporanea, è noto come “costante di Hubble”, anche se non è certissimo che sia proprio costante. E quanto vale? Per stabilirlo, gli astrofisici hanno utilizzato essenzialmente due tipi di approcci: da una parte sono partiti misurando i parametri fondamentali dell’universo all’epoca del Big Bang con sonde cosmologiche, come WMAP della NASA e Planck dell’ESA. Ma c’è almeno un altro approccio per calcolare la costante di Hubble, ed è quello (vedi schema qui sotto) che fa uso di due particolari tipi di stelle di riferimento: le supernove di tipo Ia, stelle che esplodono emettendo una quantità di luce costante, e le cefeidi, stelle che invece pulsano con una frequenza correlata con la loro vera luminosità. Caratteristiche, queste, che consentono agli astronomi di calcolare in modo preciso la distanza di queste stelle da noi, e dunque la distanza reciproca delle galassie che le ospitano. Dato fondamentale, è facile intuirlo, per derivare poi la costante di Hubble.

Schema dei passaggi seguiti da Riess e colleghi per ricalcolare la costante di Hubble (cliccare per ingrandire). Crediti: NASA, ESA, A. Feild (STScI) e A. Riess (STScI/JHU)

La cosa impagabile di questi due approcci è che sono alquanto indipendenti l’uno dall’altro. Perfetti, perciò, per confermarsi a vicenda: se tutto va come ci si attende, messi in conto gli inevitabili errori nella stima, i due valori dovrebbero essere sovrapponibili. Ma uno studio in uscita su The Astrophysical Journal, basato su dati raccolti dal telescopio spaziale Hubble – che ha osservato 300 supernove di tipo Ia e 2400 cefeidi, studio guidato fra l’altro da Adam Riess, premio Nobel per la Fisica nel 2011 proprio per aver confermato che l’espansione dell’universo sta accelerando – trova un valore per la costante di Hubble significativamente più elevato rispetto a quello derivato dalle misure cosmologiche. E ciò che è peggio è che, anche considerando i margini d’errore – ridottissimi per quest’ultima misura – i due risultati non si sovrappongono più. È un po’ come costruire un tunnel cominciando a scavare dalle due estremità, e ritrovarsi a metà strada con le due gallerie che non s’incontrano… Ora si tratta di capire perché.

Ci stanno provando, fra gli altri, Eleonora Di Valentino e Alessandro Melchiorri, ricercatrice postdoc in Francia la prima, presso l’Institut Astrophysique di Parigi, e professore alla Sapienza, nonché associato INAF, il secondo. Insieme a Joseph Silk, di Oxford, hanno appena messo in rete un preprint (un articolo ancora in attesa di peer review) che affronta proprio questa discrepanza. Media INAF li ha intervistati.

Partiamo dall’oggetto del contendere: la costante di Hubble. Vale a dire, il tasso d’accelerazione dell’espansione dell’universo. Qual è il valore oggi comunemente accettato? E quanto il team di Riess suggerisce invece che sia, in base ai dati Hubble?

«Il punto è che non c’è al momento un valore comunemente accettato. È possibile misurare la costante di Hubble (H0) in maniera diretta», spiega Di Valentino, «come fanno Riess e colleghi, o in maniera indiretta (vale a dire assumendo un modello cosmologico), come si fa con la radiazione di fondo cosmico (CMB). Già la CMB pre-Planck preferiva un valore minore rispetto a quello misurato in modo diretto dallo Hubble Space Telescope (HST). Questa tensione, che era a livello di 2 deviazioni standard appena quando i nuovi dati di Planck sono stati rilasciati, si è adesso inasprita a 3.3 deviazioni standard con la nuova analisi di Riess et al. Questo sta a indicare che maggiore è la precisione con cui H0 viene misurata, maggiore diventa la tensione tra le due misure. Riess e il suo team ottengono così un valore pari a 73.2 km al secondo per megaparsec [ndr: che corrisponde suppergiù a 263 mila km/h in più ogni 3.26 milioni di anni luce di distanza], con un intervallo d’errore di più o meno 1.75 km/s/Mpc, mentre i dati di Planck, assumendo il modello cosmologico standard, forniscono 66.93 più o meno 0.62 km/s/Mpc».

Quali possono essere le ragioni di questa discrepanza? Sbaglia Planck? Sbaglia Hubble? O c’è qualche altra possibilità?

«La discrepanza può essere dovuta a sistematiche in uno dei due esperimenti», dice Melchiorri, «ma dopo cinque anni di analisi dati comincia a essere difficile che vi siano grandi errori. La possibilità più interessante è che entrambi abbiano ragione e che vi sia una nuova fisica a spiegare la discrepanza. Nel nostro articolo mostriamo che la via migliore consiste nel cambiare l’equazione di stato dell’energia oscura. Una cosa abbastanza ragionevole, visto che di questa componente non sappiamo nulla».

In tutto ciò cosa c’entrano i neutrini? Vedo che nel vostro articolo vi fate riferimento…

«Riess e colleghi hanno proposto delle specie di neutrini “extra”, per esempio i neutrini sterili, per risolvere la tensione. Nel nostro articolo facciamo però vedere», osserva Melchiorri, «che questa non è la via migliore, dato che il fit [ndr: la corrispondenza] con i dati peggiora».

Dunque quali alternative proponete, nel vostro articolo?

«Come prima cosa presentiamo un’analisi considerando allo stesso tempo tutte le possibili soluzioni note. In pratica estendiamo l’analisi dai 6 parametri usuali a 12. In secondo luogo», continua Di Valentino, «mostriamo che la soluzione migliore consiste nel considerare modelli di energia oscura con equazione di stato negativa (w < -1). Questo si può ottenere in molti modi diversi, ma il punto importante è che la costante cosmologica non sarebbe più sufficiente».

Ha forse qualcosa a che fare con quello che chiamate “phantom-like dark energy component”? Di che si tratta?

«L’origine del nome “phantom” deriva da un articolo di Robert Caldwell che si rifaceva al primo film della seconda trilogia di Lucas, Phantom menace: La minaccia fantasma. Infatti in questo modello l’energia oscura è una “minaccia oscura” che produrrebbe la distruzione dell’universo tra una cinquantina di miliardi di anni», nota Melchiorri. «C’è da dire che il modello proposto non è teoricamente molto più bello del film mediocre di Lucas, ma è una possibilità».

Ma oltre alla distruzione dell’universo, che già non mi pare poco, quali conseguenze avrebbe, per l’astrofisica e per la cosmologia, una variazione così significativa della costante di Hubble?

«I dati pre-Planck potevano conciliare le misure di CMB e di HST in due modi: con una dark radiation, e quindi un numero di specie di neutrini relativistici maggiore di 3, o con una dark energy diversa dalla costante cosmologica, cioè w diverso da -1. Oggi, con Planck, la possibilità di un numero di specie di neutrini maggiore di 3 non è più praticabile. Se entrambi i risultati fossero confermati, una possibilità per metterli d’accordo è l’abbandono della costante cosmologica, difficile da spiegare dal punto di vista fisico, in favore di un fluido di dark energy con equazione di stato w < -1. Un modello phantom, appunto», conclude Di Valentino.