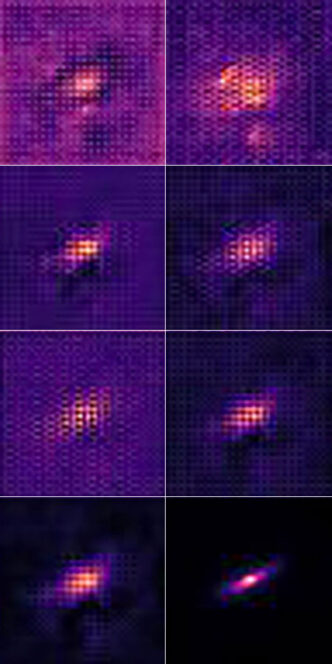

Per rimuovere da un’immagine astronomica le distorsioni introdotte dalla turbolenza atmosferica, l’algoritmo d’intelligenza artificiale messo a punto da Li e Alexander la processa a più livelli, generando sei immagini intermedie (l’immagine iniziale è in alto a sinistra; l’immagine finale è in basso a destra). Crediti: Northwestern University

Le app che migliorano la qualità delle fotografie ormai le conosciamo e le usiamo tutti. Le più moderne non si limitano a rimuovere gli occhi rossi o a correggere ombre e luci: avvalendosi di algoritmi d’intelligenza artificiale, sono in grado di compiere operazioni ben più complesse, come rimuovere oggetti in secondo piano, scontornare quelli in primo piano o – addirittura – eseguire veri e propri restauri, restituendo vita e nitidezza a vecchie stampe rovinate dal tempo.

L’impiego di algoritmi analoghi in ambito astronomico era dunque solo questione di tempo. Usato da anni per riconoscere in modo automatico – nei cataloghi delle grandi survey – oggetti celesti d’ogni sorta (lenti gravitazionali, supernove, esopianeti…), ecco infatti che il machine learning si cimenta sempre più spesso anche nel campo del “fotoritocco” spaziale. E non stiamo parlando di photoshoppare le immagini per renderle esteticamente più gradevoli, ma di vere opere di ricostruzione a scopo scientifico.

È il caso del metodo presentato questo mese su Monthly Notices of the Royal Astronomical Society da Tianao Li della Tsinghua University (Cina) ed Emma Alexander della Northwestern University (Usa). È basato sul cosiddetto physics-informed machine learning, ovvero un algoritmo di apprendimento automatico che non parte da zero, bensì avendo ricevuto in dotazione un bagaglio conoscenze pregresse di fisica e matematica. E mira a risolvere un problema molto sentito da chi si occupa di lenti gravitazionali (e in particolare di weak gravitational lensing): le distorsioni prodotte dalla turbolenza atmosferica sulle immagini delle galassie acquisite dai telescopi terrestri.

«È un po’ come guardare verso l’alto dal fondo di una piscina», spiega Alexander. «L’acqua devia la luce e la distorce. L’atmosfera, naturalmente, è molto meno densa, ma il concetto è simile». Un bel problema per gli astrofisici, che infatti adottano da anni tecniche per porvi rimedio, prima fra tutte l’ottica adattiva. Un problema non tanto estetico quanto scientifico, dicevamo. Lo studio della forma – e della deformazione – delle galassie è, per esempio, uno fra i metodi utilizzati per ricostruire le strutture cosmologiche a grande scala osservandone gli effetti gravitazionali sulla luce durante il suo tragitto verso la Terra. Effetti non appariscenti come quelli delle classiche lenti gravitazionali, ma molto più diffusi e dunque statisticamente assai rilevanti.

«Piccole differenze nella forma ci possono dire qualcosa sulla gravità nell’universo», continua Alexander. «Già queste differenze sono difficili da rilevare. Se poi osservi un’immagine acquisita da un telescopio terrestre, la forma potrebbe essere distorta. Ed è difficile sapere se è a causa di un effetto gravitazionale o dell’atmosfera». In altre parole, quando alla deformazione indotta dal weak gravitational lensing – che fa sembrare una galassia ellittica, per esempio, lievemente più rotonda o più allungata di quanto non sia realmente – si aggiungono quelle dovute alla turbolenza atmosferica e ad altre fonti di rumore strumentali, districare le diverse componenti diventa estremamente complesso, e questo in parte proprio a causa della modestia intrinseca del lensing debole, che non balza subito agli occhi.

Il tentativo di correzione a posteriori di queste distorsioni avviene con quella che viene chiamata in gergo la deconvoluzione della point spread function (Psf): è il “filtro” che consente di rendere nitida una fotografia sfocata. Ed è esattamente questo ciò che fa l’algoritmo di deep learning messo a punto da Li e Alexander (disponibile su GitHub), adattato non a caso a partire da un noto algoritmo di computer-vision impiegato in ambito fotografico.

La prima applicazione concreta dovrebbe essere sulle immagini che acquisirà a partire dal prossimo anno il Vera Rubin Observatory. Per “allenare” il loro algoritmo a dovere – come per tutti i sistemi ad apprendimento automatico, anche questo richiede una fase di addestramento – in modo che arrivi già in forma ai blocchi di partenza, Li e Alexander lo stanno facendo esercitare su dati simulati ad hoc. Alcuni risultati li possiamo vedere nelle immagini di apertura, e sembrano essere molto promettenti: l’algoritmo ha prodotto immagini con il 38.6 per cento di errori in meno rispetto ai metodi classici per la rimozione della sfocatura, scrivono i ricercatori nel loro articolo, e il 7.4 per cento di errori in meno rispetto ai metodi più moderni.

Per saperne di più:

- Leggi su Monthly Notices of the Royal Astronomical Society l’articolo “Galaxy Image Deconvolution for Weak Gravitational Lensing with Unrolled Plug-and-Play ADMM”, di Tianao Li ed Emma Alexander

- Scarica il dataset e il codice “Galaxy Deconvolution” da GitHub

Guarda una sequenza di correzione della sfocatura nel video della Northwestern University: