L’ammasso della Chioma è costituito prevalentemente da galassie ellittiche ben formate e da poche galassie a spirale giovani. L’ammasso fa parte di una serie di strutture appartenenti al superammasso della Chioma, una delle prime strutture a grande scala dell’universo ad essere state scoperte. Crediti: Nasa

Avvalendosi di algoritmi d’intelligenza artificiale basati sull’architettura delle reti neurali artificiali, un team di fisici guidato da Matthew Ho della Carnegie Mellon University (Usa) ha calcolato la massa dell’ammasso della Chioma: circa un milione e mezzo di miliardi di masse solari – un valore consistente con quanto calcolato dalle stime precedenti. Il risultato è stato pubblicato il mese scorso su Nature Astronomy.

I sistemi di intelligenza artificiale basati sulle reti neurali permettono di addestrare gli algoritmi attraverso dataset in input, così che siano poi in grado di analizzare successivamente nuovi dati in modo autonomo, senza bisogno di conoscere alcun modello. Gli ammassi di galassie sono sistemi fisici complessi a N-body e calcolare la dinamica di queste strutture nelle simulazioni richiede dei tempi computazionali che aumentano esponenzialmente con la complessità del sistema. Le reti neurali permettono di risolvere problemi di questo tipo e prevedere le proprietà dinamiche dell’ammasso senza un calcolo diretto delle equazioni differenziali che descrivono il modello, consentendo così un abbattimento dei tempi di calcolo.

L’ammasso della Chioma si trova a circa 350 milioni di anni luce di distanza dalla Terra, in direzione dell’omonima costellazione. Questo ammasso, catalogato come Abell 1656, ha avuto una certa importanza nella storia dell’astrofisica: fu studiato negli anni ‘30 dall’astronomo svizzero Fritz Zwicky per predire l’esistenza della materia oscura. Applicando il teorema del viriale, Zwicky notò che non veniva rispettato: le velocità intrinseche delle galassie – determinate grazie allo spostamento Doppler – erano troppo elevate affinché Abell 1656 rimanesse in equilibrio. Zwicky ipotizzò così l’esistenza di materia oscura non visibile, necessaria a permettere all’ammasso di rimanere in equilibrio dinamico e di spiegare così la velocità orbitale delle galassie.

Ma torniamo all’intelligenza artificiale: le architetture basate sulle reti neurali vengono chiamate anche sistemi di deep learning, ovvero apprendimento profondo. Questi algoritmi vengono già usati in molteplici applicazioni, come il riconoscimento facciale e il riconoscimento automatico del linguaggio parlato (come per esempio le applicazioni di riconoscimento vocale Alexa e Siri), così come nell’ambito della bioinformatica, per rappresentare la struttura delle proteine complesse, e nei modelli di scienze climatiche. Un’altra applicazione di deep learning di cui si è parlato a lungo sui media è il software AlphaGo, sviluppato da Google: nel marzo 2016 riuscì per la prima volta a battere un essere umano al gioco da tavolo go. In quell’occasione Lee Sedol, campione mondiale sud coreano, fu battuto quattro volte su cinque dall’algoritmo. Per intenderci, la griglia standard di go contiene 19 x 19 caselle: è stato calcolato che il numero di tutte le combinazioni possibili sulla tavola sia dell’ordine di 10170, quasi cento ordini di grandezza superiore al numero stimato di atomi nell’universo, 1080.

Ho e colleghi hanno usato algoritmi di deep learning analoghi per predire la massa dell’ammasso di Abell 1656. Per allenare il loro modello si sono avvalsi di dati presi da alcune simulazioni della distribuzione di materia nell’universo. L’algoritmo ha così imparato a osservare le caratteristiche di migliaia di ammassi di galassie la cui massa viene calcolata da questi modelli. Successivamente i ricercatori hanno applicato il modello a un sistema reale, la cui massa è conosciuta, per confrontarne i risultati e provare l’affidabilità dell’algoritmo. Questo è uno dei primi esempi di applicazione di intelligenza artificiale profonda per lo studio di strutture a grande scala dell’universo.

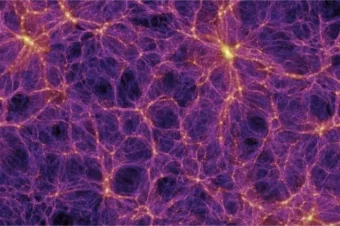

Struttura a larga scala dell’universo del Millenium Simulation Project, fatta attraverso una simulazione N-body di 10 miliardi di particelle. I filamenti e i nodi degli ammassi di galassie sono separati da vuoti di materia. Crediti: Millenium Simulation Project

«Dalle survey dei telescopi spaziali sono stati raccolti petabyte di dati. Una quantità enorme», dice Ho. «Impossibile per degli esseri umani analizzarli direttamente a mano. Il nostro team lavora per costruire modelli che possono essere affidabili estimatori di quantità, come la massa, e allo stesso tempo cercando di mitigare le sorgenti di errori. Un altro aspetto importante è che gli algoritmi, per processare questo vasto flusso di dati, devono essere computazionalmente efficienti. Ed è esattamente quello che stiamo cercando di fare: usare algoritmi di machine learning per migliorare le nostre analisi e renderle più veloci». Per produrre i risultati, il team di Ho ha usato le risorse del Pittsburgh Supercomputing Center e dataset di diversi database, come per esempio quello del CosmoSim, che raccoglie dati di migliaia di ammassi a diversi redshift, e quelli prodotti dalle simulazioni N-body Uchuu.

Gli ammassi di galassie si presentano come nodi in una vasta rete di materia distribuita più o meno omogeneamente nell’universo. Survey di spettroscopia a larga scala come quelle compiute da Desi, il Dark Energy Spectroscopic Instrument, hanno infatti raccolto dati di milioni di galassie (si prevede che il catalogo di Desi, a fine 2026, conterrà oltre 35 milioni di oggetti), fino a una distanza di 10 miliardi di anni luce. In questo modo è possibile ricostruire una mappa 3D del cosmo e attraverso le analisi spettroscopiche misurarne il redshift. L’analisi della struttura a grande scala dell’universo attraverso le osservazioni di Desi e di altre survey di galassie sarà essenziale poi per confrontare i dati con i risultati di simulazioni della distribuzione della massa nei diversi modelli cosmologici. L’intelligenza artificiale aiuterà i ricercatori a elaborare tutti questi dati e produrre previsioni affidabili delle strutture a grande scala dell’universo.

Per saperne di più:

- Leggi su Nature Astronomy l’articolo “The dynamical mass of the Coma cluster from deep learning”, di Matthew Ho, Michelle Ntampaka, Markus Michael Rau, Minghan Chen, Alexa Lansberry, Faith Ruehle & Hy Trac