Poter disporre di grandi quantità di dati è certamente una bella cosa, ma i big data pongono anche qualche problema: la loro abbondanza può mettere in ginocchio i programmi che devono analizzarli, che ovviamente non possono disporre di risorse computazionali infinite. È la situazione che si trovano – e sempre più si troveranno – ad affrontare, per esempio, modelli come Eftoflss (Effective Field Theory of Large-Scale Structure), messi a punto combinando la cosmologia con i dati raccolti da survey e strumenti come Boss, Euclid e Desi. Modelli che hanno come obiettivo quello di descrivere statisticamente la “rete cosmica” e di consentire di stimarne i parametri chiave.

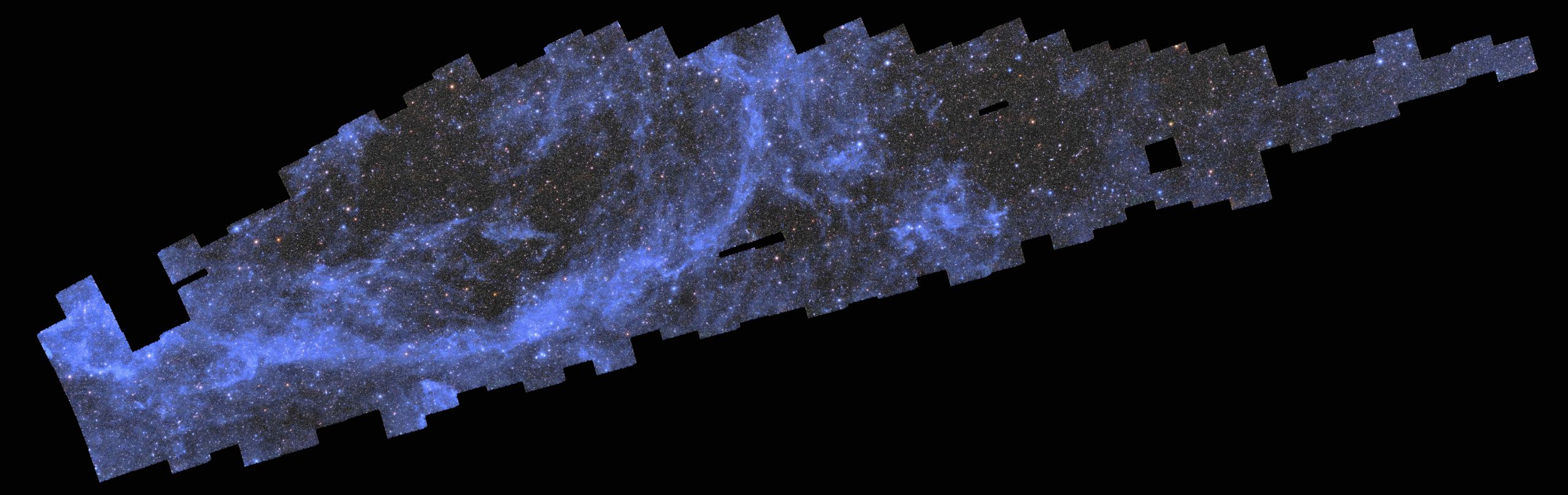

Mosaico di 260 osservazioni realizzate da Euclid tra il 25 marzo e l’8 aprile 2024, con circa 14 milioni di galassie. Crediti: Esa/Euclid/Euclid Consortium/Nasa, Cea Paris-Saclay, image processing by J.-C. Cuillandre, E. Bertin, G. Anselmi

CC BY-SA 3.0 IGO

Come fare? Una soluzione è quella di ricorrere agli emulatori: programmi che “imitano” il modo in cui i modelli rispondono, ma che “alleggerendo” il processo di analisi riescono a funzionare molto più velocemente. Insomma, una sorta di scorciatoia. Se il trucco permette di risparmiare tempo, il rischio è però quello di perdere in accuratezza. Ed è proprio per stimare questa perdita che un team di quattro ricercatori dell’Inaf e delle università di Parma, di Waterloo (Canada) e di Aix Marseille (Francia) ha messo alla prova Effort.jl, un emulatore da loro progettato.

I risultati, pubblicati ieri sul Journal of Cosmology and Astroparticle Physics (Jcap), sono a dir poco rassicuranti: pur fatto girare su un laptop standard invece che su un supercomputer, Effort.jl riesce a completare il lavoro in pochi minuti offrendo essenzialmente la stessa accuratezza del modello che imita, a volte addirittura con dettagli ancora più precisi.

«Immaginate di voler studiare il contenuto di un bicchiere d’acqua a livello dei suoi componenti microscopici, i singoli atomi, o anche più piccoli: in teoria si può fare. Ma se volessimo descrivere in dettaglio cosa succede quando l’acqua si muove, la crescita esplosiva dei calcoli necessari renderebbe l’impresa praticamente impossibile», spiega il primo autore dello studio, Marco Bonici, ricercatore all’Università di Waterloo. «Tuttavia, è possibile codificare alcune proprietà a livello microscopico e vedere il loro effetto a livello macroscopico, vale a dire il movimento del fluido nel bicchiere. Questo è ciò che fa una teoria di campo efficace, ovvero un modello come Eftoflss, dove l’acqua del mio esempio è l’universo su scale molto grandi, mentre i componenti microscopici sono processi fisici su piccola scala».

«Il nostro emulatore», aggiunge un’altra autrice dello studio, Carmelita Carbone, dell’Inaf Iasf di Milano, riferendosi a Effort.jl, «riesce a riprodurre le proprietà statistiche della distribuzione delle galassie con la precisione necessaria per analizzare dati di survey come Euclid e Desi. Il vantaggio principale sta nella velocità di calcolo: mentre sistemi tradizionali richiedono giorni o settimane per effettuare l’analisi, il nostro emulatore permette di ottenere gli stessi risultati in una manciata d’ore».

Per capire come ci riesca, teniamo anzitutto presente come funziona il processo standard: le osservazioni astronomiche vengono inserite nel codice e il modello teorico spiega statisticamente la struttura che dà origine ai dati, calcolando una “previsione”. Ma questo richiede tempo e una notevole potenza di calcolo.

Un emulatore essenzialmente imita ciò che fa il modello: il suo nucleo è una rete neurale che impara ad associare i parametri di input – le osservazioni astronomiche – alle previsioni calcolate dal modello che vuole imitare. La rete viene addestrata sui risultati del modello e, dopo l’addestramento, diventa in grado di estrarre nuove combinazioni di parametri. L’emulatore dunque non “comprende” la fisica in sé: conosce però le risposte del modello teorico bene al punto da riuscire ad anticipare ciò che produrrebbe per un nuovo input.

In particolare, sottolineano gli autori dello studio, l’originalità di Effort.jl consiste nel ridurre la fase di addestramento integrando nell’algoritmo le conoscenze che già si possiedono su come cambiano le previsioni quando cambiano i parametri: invece di far “riapprendere” questi ultimi alla rete, li utilizza fin dall’inizio. Effort.jl utilizza anche i gradienti, ovvero “quanto e in quale direzione” cambiano le previsioni se si modifica leggermente un parametro, un altro elemento che aiuta l’emulatore ad apprendere da un numero molto inferiore di esempi, riducendo le esigenze di calcolo e consentendogli di girare su macchine più piccole.

Uno strumento come questo necessita di una validazione approfondita: se l’emulatore non conosce la fisica, come possiamo essere sicuri che la “scorciatoia” produca comunque risposte corrette – cioè le stesse che darebbe il modello? Lo studio appena pubblicato risponde proprio a questa domanda, dimostrando che l’accuratezza di Effort.jl, sia sui dati simulati che su quelli reali, è in stretta concordanza con il modello. «E in alcuni casi, in cui con il modello sarebbe necessario sacrificare parte dell’analisi per velocizzare le cose, con Effort.jl siamo stati in grado di includere anche le parti mancanti», conclude Bonici.

Per saperne di più:

- Leggi sul Journal of Cosmology and Astroparticle Physics l’articolo “Effort.jl: a fast and differentiable emulator for the Effective Field Theory of the Large Scale Structure of the Universe”, di Marco Bonici, Guido D’Amico, Julien Bel e Carmelita Carbone