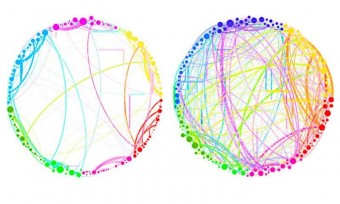

In questo diagramma, i risultati semplificati che possono essere ottenuti grazie all’analisi quantistica d’insiemi di dati enormi e complessi. Sono rappresentate le connessioni fra diverse regioni del cervello in un soggetto di controllo (a sinistra) e in un soggetto sotto l’influenza d’una sostanza psichedelica, la psilocibina (a destra). Si nota un drammatico aumento della connettività, che spiega alcuni degli effetti della droga (come il “sentire” i colori o il “vedere” gli odori). Un’analisi come questa, che coinvolge miliardi di cellule cerebrali, è troppo complessa per le tecniche tradizionali, ma potrebbe essere gestita facilmente dal nuovo approccio quantistico, dicono i ricercatori. Crediti immagine: Petri et al. / Proceedings of the Royal Society Interface. Fonte: http://bit.ly/1tRMgsf

Non esiste sporco impossibile, recitava un celebre claim pubblicitario di fine anni Sessanta. Sporco forse no, ma problemi praticamente impossibili da risolvere ce ne sono eccome. Parliamo in particolare di problemi computazionali: teoricamente risolvibili, magari, ma solo a patto di poter disporre d’un numero spaventoso di processori – paragonabile, per intenderci, a tutte le particelle presenti nell’Universo. E dunque senza speranza di poter essere realisticamente affrontati.

Eppure, cambiando radicalmente sia l’approccio a questi problemi sia il tipo di computer, ecco aprirsi vie inesplorate ma percorribili per aggredire anche le pareti computazionali più ripide, “sesti gradi” della big computation come l’analisi delle enormi quantità di dati prodotti dagli attuali esperimenti scientifici – dalla genetica all’economia, dallo studio del cervello a quello dell’universo. Ebbene, una di queste “vie” è appena stata inaugurata – e descritta sulle pagine di Nature Communications – da tre scienziati, due dei quali italiani (anche se entrambi all’estero): Seth Lloyd del Massachusetts Institute of Technology (MIT), Silvano Garnerone della University of Waterloo e Paolo Zanardi della University of Southern California.

Di che “via” si tratta? Andiamo per ordine. Diverso approccio e diversi computer, dicevamo. Il diverso approccio, in questo caso, è quello topologico: un paio d’occhiali magici – o meglio, matematici – che fa vedere il mondo come se fosse formato solo da buchi e connessioni. Un esempio? Prendiamo le 26 lettere maiuscole dell’alfabeto latino. A noi appaiono tutte diverse, altrimenti non potremmo leggere, ma attraverso gli occhiali della topologia il loro numero si ridurrebbe a 3: c’è la ‘B’, con i suoi due buchi; c’è il gruppo di lettere con un buco soltanto, ovvero la ‘A’, la ‘D’, la ‘O’, la ‘P’, la ‘Q’ e la ‘R’; e infine tutte le altre, che di buchi ne hanno zero. Da 26 a 3, una semplificazione niente male. Ma il grande vantaggio è un altro: la topologia coglie la quintessenza d’una forma, ciò che la rende tale indipendentemente da una serie di trasformazioni. Se il materiale è il pongo e la regola dice “pasticcia quanto ti pare, ma non creare e non distruggere buchi”, ecco che posso trasformare un anello in una tazza con il manico (entrambe forme con un buco) ma non in un paio di forbici, che di buchi ne ha due e che al limite può diventare una lettera ‘B’, appunto, o un paio di rudimentali manette. Uno strumento d’analisi straordinario, dunque, per studiare sistemi elastici – che possono essere compressi, o schiacciati o distorti – come, per esempio, una rete (informatica, economica, sociale, neurale…) con tutti i suoi nodi.

Uno strumento potentissimo, la topologia, ma non sufficiente. Non, almeno, con i computer “normali”: se consideriamo un insieme di dati con 300 punti, spiega per esempio Lloyd, l’analisi di tutte le sue caratteristiche topologiche richiederebbe 2300 processori, ovvero 2 moltiplicato per se stesso 300 volte: più processori, appunto, che particelle nell’Universo. Ma se fosse possibile trovare una soluzione che scardini quel “300” dalla posizione esponenziale… ebbene, quella soluzione c’è, e si chiama computer quantistico. Con un approccio quantistico, scrivono i tre autori, la complessità computazionale si riduce drasticamente, passando da un numero nell’ordine di 2300 a uno più vicino a 3002. Detto altrimenti, la difficoltà del problema, da esponenziale, diventa polinomiale. Sempre difficile, intendiamoci, ma non più impossibile.

Fantascienza, dite? Tutt’altro. I computer quantistici esistono già. «Qui alla University of Southern California, dove sono professore da una decina d’anni», dice Zanardi ai microfoni di Media INAF, «abbiamo un dispositivo, D-Wave, che è un computer quantistico (o un passo importante in direzione del computer quantistico ), nel nostro caso a 1000 qubit. Ecco, se potessimo implementare nel nostro D-Wave l’algoritmo che abbiamo descritto nel paper, potremmo caratterizzare delle figure con qualche decina di punti. Se però volessimo avere un’applicazione importante dovremmo avere dei computer molto più grandi. I computer quantistici ci sono già, dunque, ma quelli disponibili sono ancora troppo piccoli. Visto però il grande interesse e la conseguente grande quantità di fondi che – almeno negli Stati Uniti – si stanno riversando su questo settore, nell’arco di pochi anni saranno disponibili dispositivi per il quali il nostro algoritmo può essere utilizzato a fini pratici».

Fini pratici, val la pena sottolinearlo, che sfiorano i campi d’interesse più vari, dallo spazio alla neurologia. L’altro coautore italiano dell’articolo, per esempio, Silvano Garnerone, è da poco tornato in Europa, «non Italia, perché questo non è facile», sottolinea Zanardi, che è stato suo docente, «e pur essendo un fisico teorico lavora in un laboratorio di biologia molecolare, dove si occupa di big data applicati alla ricerca sul cancro».

Per saperne di più:

- Ascolta l’intera intervista a Paolo Zanardi (da Los Angeles, via Skype), dove si parla anche dei numeri di Betti, altro italiano protagonista della topologia

- Leggi su Nature Communications l’articolo “Quantum algorithms for topological and geometric analysis of data“, di Seth Lloyd, Silvano Garnerone e Paolo Zanardi